在看到 Google 的 公开信 后,我在 Twitter 上说”宁与玉碎不为瓦全。也好”。之后一直想写点什么,不过在这个时候,阐述对这件事情的看法,很难不被淹没到口水战里。

揣测 Google 这样做的动机与商业目的对我们大多数人来说没有什么实际意义,不如让我们把讨论的焦点放在这次事件背后的问题上:这次实际上是客观承认了”内容审查”(refer: Censorship)变本加厉的既定事实,也让更多人知道了这一现状对社会带来的负面作用。对互联网的不当隔离与审查是不符合普世价值的,尤其不符合人民群众对于”先进生产力的发展要求“,是民众无法认同与接受的做法。Google 对于互联网来说是先进生产力的绝对代表者,如果将其拒之门外,那么可以肯定这无助于社会的进步。

如果说出于政治目的的审查有其可解释性,但是为了”倒洗澡水而把孩子也倒掉”则是极其错误的做法(当然,表面上都是以一些类似”保护未来的花朵”为借口,这和过去那些重大对立冲突的导火索何其相似也)。这种错误的做法还包括前一段时间的 IDC 整顿、域名整顿等一系列事件乃至要推行网站白名单的传说,这些都是操作层面上的极度不当。”疏”与”堵”,历史给我们带来无数次的经验教训,后者无疑是饮鸩止渴。我不知道在皇帝的新装的那个故事中,喊出来那家伙其实什么也没穿的小孩受到了什么对待,也不知道皇帝是否再次上演新装的闹剧。是在我们这里,似乎这样的闹剧无时无刻都在上演。

上网十年,从一个乐观者变成了悲观者。历史有的时候是进一退二,有的时候是以退为进,还是让我再乐观一次吧,期待 Google 这次准备撤离会唤醒我们更多的思考,给我们带来哪怕是一点点的进步。

–EOF–

更新:

在审查过程中造成的直接和间接的经济损失似乎少有人关注,不知道是否有经济学人关注这一领域。如果有人算一笔经济账,恐怕会是个惊人的数字。而有关部门相信也是投入了大量人力物力的,这也是不小的资金开销。

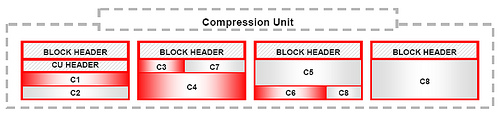

我们知道 Oracle 数据库引擎默认是以数据块(block)为存储单位,以数据行(row)作为存储与组织方式,当然理想情况是在一个数据块内存储更多的数据行,而实际上这样的方式对于一些列数较多的表不可避免的会带来存储空间的浪费。相反,以列(columnar)的方式组织、存储数据在空间上会带来很好的收益,但是对于依赖于行的查询,也是我们最常用的查询方式,则性能会差很多,而对于数据分析方面常见的汇总之类的查询,因为只需要扫描较少的数据块,就会达到很好的性能。可实际环境中,人们往往要熊掌与鱼兼得,为了达到空间和性能上的折衷,Oracle 引入了新的方式:用行与列混合的方式来存储数据。

我们知道 Oracle 数据库引擎默认是以数据块(block)为存储单位,以数据行(row)作为存储与组织方式,当然理想情况是在一个数据块内存储更多的数据行,而实际上这样的方式对于一些列数较多的表不可避免的会带来存储空间的浪费。相反,以列(columnar)的方式组织、存储数据在空间上会带来很好的收益,但是对于依赖于行的查询,也是我们最常用的查询方式,则性能会差很多,而对于数据分析方面常见的汇总之类的查询,因为只需要扫描较少的数据块,就会达到很好的性能。可实际环境中,人们往往要熊掌与鱼兼得,为了达到空间和性能上的折衷,Oracle 引入了新的方式:用行与列混合的方式来存储数据。